|

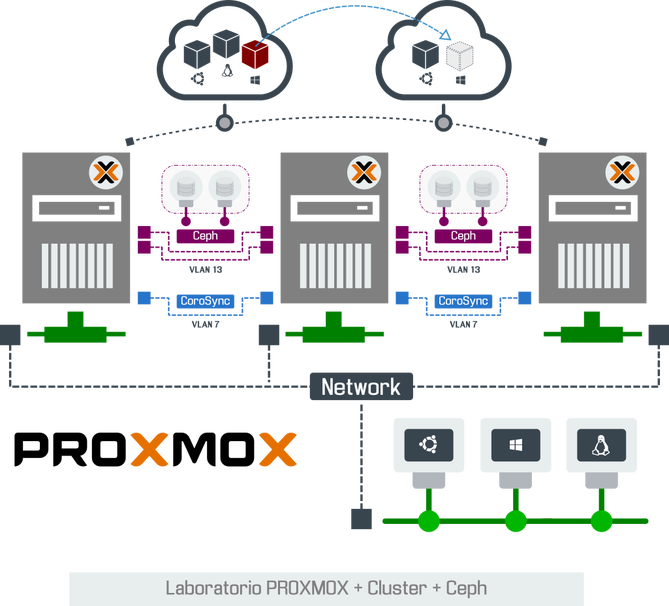

El siguiente artículo describe los pasos para crear un Cluster en PROXMOX con "Alta Disponibilidad" sobre un entorno Virtualizado. El objetivo es conocer a fondo PROXMOX Cluster, Ceph, "Alta Disponibilidad" entre otras características y beneficios para llevarlo a un entorno productivo.

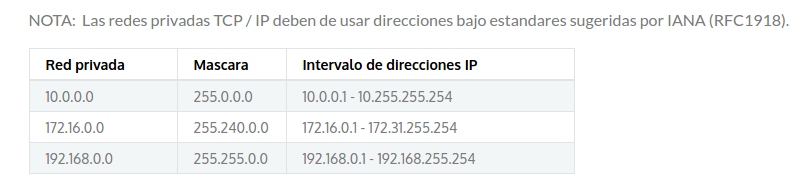

NOTA:

Laboratorio PROXMOX + Cluster + Ceph + HA

Pasos a seguir para activar Cluster PROXMOX + Ceph y Alta Disponibilidad

1. ¿Qué es Ceph? 2. Habilitar "Nested Virtualization" en PROXMOX 3. Creación de "Máquinas Virtuales" en PROXMOX 4. Preparar "Máquinas Virtuales" para Cluster 5. Activar Cluster PROXMOX 6. Preparar enlaces en "Máquinas Virtuales" para Ceph 7. Agregar Disco Duros en Nodos para Ceph 8. Instalar librerías Ceph y Activación de Servicio 9. Presentar "Bloques de espacio" al Cluster 10. Pruebas de "Migración" y "Alta Disponibilidad" 1. ¿Qué es Ceph?

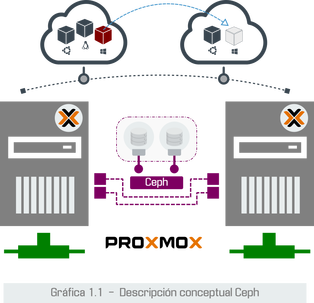

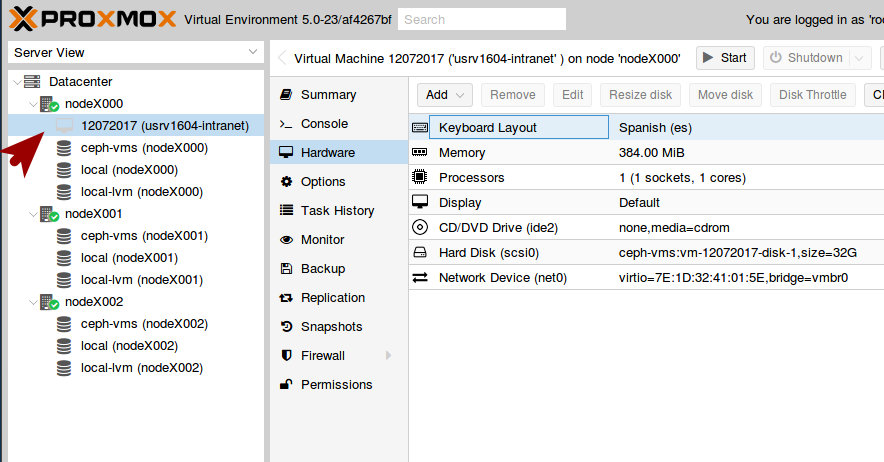

Los "Nodos" puede almacenar en el "Storage Ceph" los "Discos Virtuales" de las "Máquinas Virtuales (VM's) y Contenedores (LXC)", habilitando en el Cluster la posibilidad de "Migrar/Mover" las "Máquinas Virtuales" entre cada Nodo y definir reglas de "Alta Disponibilidad".

Este es un breve resumen de lo que podemos esperar de Ceph para este laboratorio. Se sugiere entrar en más detalle técnico a través de la página oficial: www.ceph.com y Wikipedia (Más información haga clic en cada link).

Adicional: Es importante conocer como funciona PROXMOX Cluster, por tal razón sugerimos ver el link:

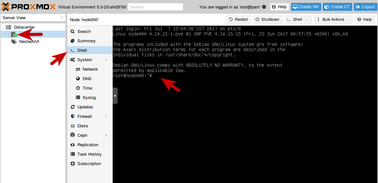

2. Habilitar "Nested Virtualization" en PROXMOX

El laboratorio requiere tres "Máquinas Virtuales" y queda a su criterio el Host Hipervisor, sin embargo en este artículo sugerimos configurar un servidor PROXMOX 4.x/5.x con "Nested Virtualization".

Si desea repasar los pasos para instalar PROXMOX, haga clic en el siguiente link:

Bueno, Ahora si... Después de tanto misterio iniciamos con la configuración...

Dependiendo de nuestro procesador, ejecutamos los siguientes comandos:

No es necesario reiniciar el servidor, sin embargo para asegurarnos que todo funcione adecuadamente se sugiere reiniciar el servidor y validar que todo inicie adecuadamente. 3. Creación de "Máquinas Virtuales" en PROXMOX

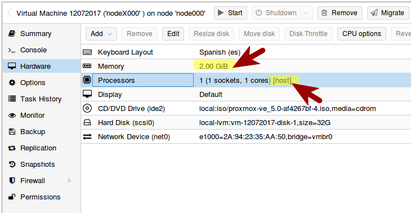

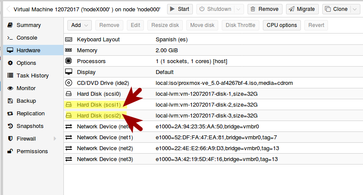

Después de habilitar "Nested Virtualization" en el host PROXMOX, iniciamos con la creación de las "Máquinas Virtuales" con las siguientes características:

Gráfica 3.2 - Máquinas Virtuales con PROXMOX Iniciamos con el proceso de instalación de PROXMOX VE en cada Servidor/Nodo.

3.3 Especificaciones de IP's y Hostname

Primer servidor Virtual (Primario):

Importante!

Después de efectuar la instalación de los tres servidores es conveniente actualizar. Ejecute en una terminal o Proxmox Shell:

4. Preparar "Máquinas Virtuales" para Cluster

En un Cluster PROXMOX se debe definir uno de los Nodos como "Orquestador" con el objetivo de centralizar el trabajo, sin embargo cada nodo cuenta con su propio administrador Web.

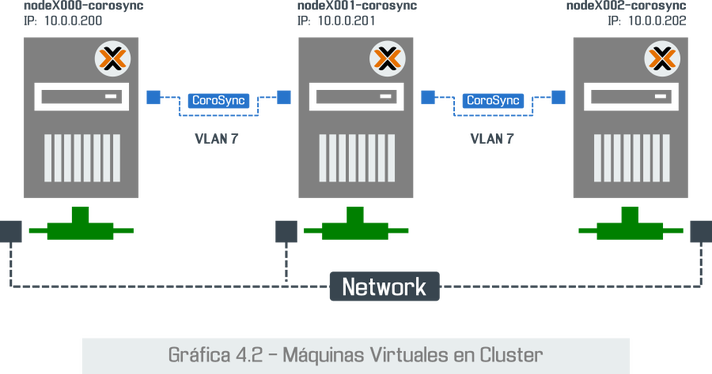

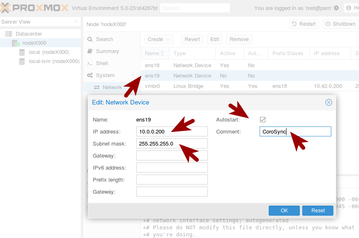

Una de las ventajas de crear un "Cluster" es la habilitación de "Alta Disponibilidad" que en resumen, es definir reglas de migración automática a las "Máquinas Virtuales", entre los Nodos en caso de eventualidades. Para ellos es muy importante la comunicación entre los miembros de Cluster y esta tarea lo efectúa "CoroSync" (Clic para más información técnica). La documentación oficial de PROXMOX sugiere separar la comunicación del Cluster (CoroSync) del enlace de Red y Storage. En este artículo vamos explicar los pasos para configurar el Cluster en un enlace dedicado para CoroSync.

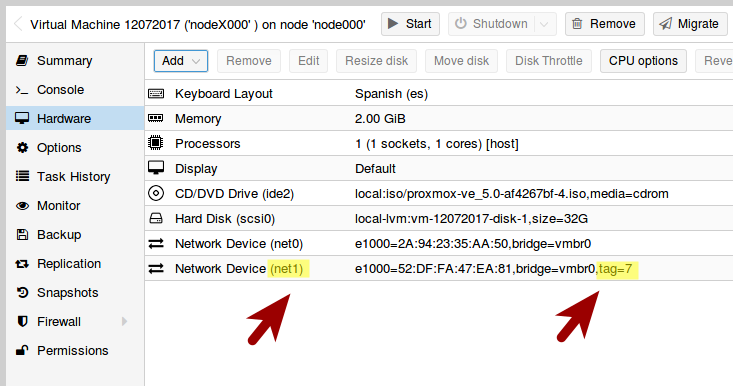

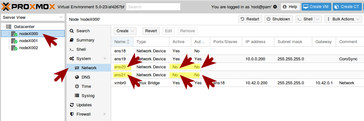

Gráfica 4.2 - Configuración Tarjeta de Red para Cluster (CoroSync) Después de agregar las "Tarjetas Virtuales" a los Nodos, es necesario ingresar al administrador Web de cada unidad y configurar la tarjeta de Red con una IP válida. Tome en cuenta que la tarjeta esta agrupada en la VLAN 7.

Después de efectuar estos cambios, es conveniente agregar en cada Nodo un Mapa de las "Tarjetas de Red". Con esto nos aseguramos que los servicios del Cluster PROXMOX se conmute por los canales adecuados.

4.5 Configuración hosts

Editamos en cada Nodo el archivo que nos permite definir y resolver direcciones: vi /etc/hosts

Agregamos lo siguiente:

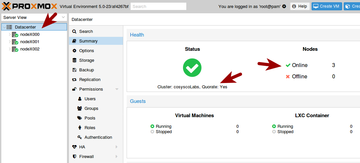

Importante! Después de esta configuración es necesario reiniciar los tres Nodos. 5. Activar Cluster PROXMOX

La activación del Cluster PROXMOX, es un proceso bastante sencillo que lleva 2 pasos:

En publicaciones anteriores del "911-ubuntu" sobre "Instalación de PROXMOX y cómo crear un Cluster", presentamos un escenario sencillo donde los Nodos cuentan con una sola "Tarjeta de Red", por tal razón no conllevaba mayor diligencia. En esta documentación se tiene un enlace separado para la comunicación del Cluster (CoroSync).

Intercambio de "Llaves Públicas" entre Nodos y Activación de Cluster

PROXMOX utiliza el "Alias" de los Nodos para entrelazar los servicios y efectuar las gestiones requeridas vía SSH, por tal razón nos vamos a asegurar que cada Nodo tenga las "Llaves Públicas" de cada uno de los miembros del Cluster. Vamos a repetir los siguiente pasos para cada Nodo:

6. Preparar enlaces en "Máquinas Virtuales" para Ceph

Para habilitar "Alta Disponibilidad" en PROXMOX es necesario contar con un mínimo de tres Nodos y un Storage que centralice los "Discos Virtuales" de las "Máquinas Virtuales" y "Contenedores".

En "Entornos Empresariales" vamos a encontrar SAN/NAS brindado "Bloques de Espacio" (Lun's FC & iSCSI, NFS) con "Tolerancia a Fallos", permitiendo la conexión de múltiples Nodos PROXMOX y la habilitación de "Alta Disponibilidad" entre ellos. Más información: PROXMOX NAS/SAN. En el siguiente artículo vamos a presentar los conceptos básicos de almacenamiento basado en NAS/SAN y como funciona en entornos virtualizados PROXMOX.

Nota: Los conceptos que vamos a emplear para habilitar "Alta Disponibilidad" en el Cluster son similares para entornos con SAN/NAS.

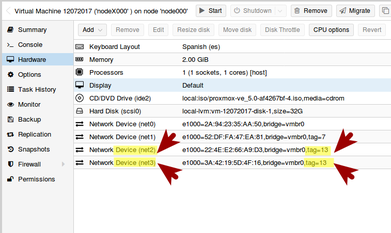

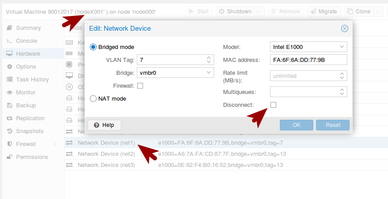

6.1 Agregar tarjetas de Red a las "Máquinas Virtuales".

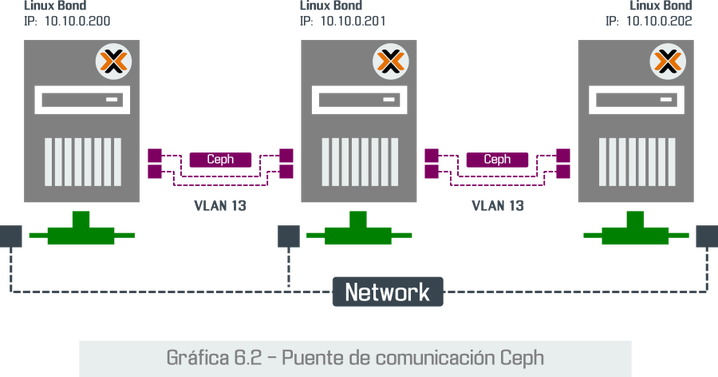

Gráfica 6.2 - Puente de comunicación Ceph

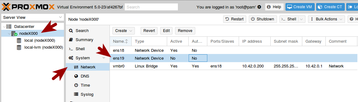

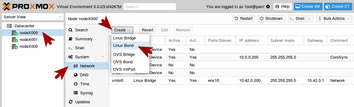

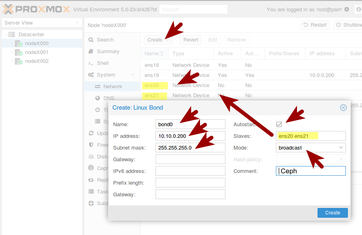

Después de agregar las "Tarjetas Virtuales" a los Nodos, es necesario ingresar al Administrador Web del Cluster y agregar en cada unidad un "Linux Bond" que entrelace las dos nuevas tarjetas. Tomar nota que ambas tarjetas están agrupadas en la VLAN 13.

Para esta parte del artículo, los Nodos están en Cluster y es mucho más fácil acceder a cada uno de ellos. Entonces, siguiendo el esquema COSYSCO.NETWORK, vamos a configurarlo de la siguiente forma:

Información Técnica: Linux Bond se presenta como un Interfaz Virtual que entrelaza dos o más "Tarjetas de Red", brindando un enlace tolerante a "Fallos" y de alto rendimiento en "Transferencia de datos". Para utilizar "Ceph Storage" es necesario contar con enlaces que conmute de forma eficiente. Vamos a configurar "Linux Bond" en cada Nodo del Cluster de la siguiente forma:

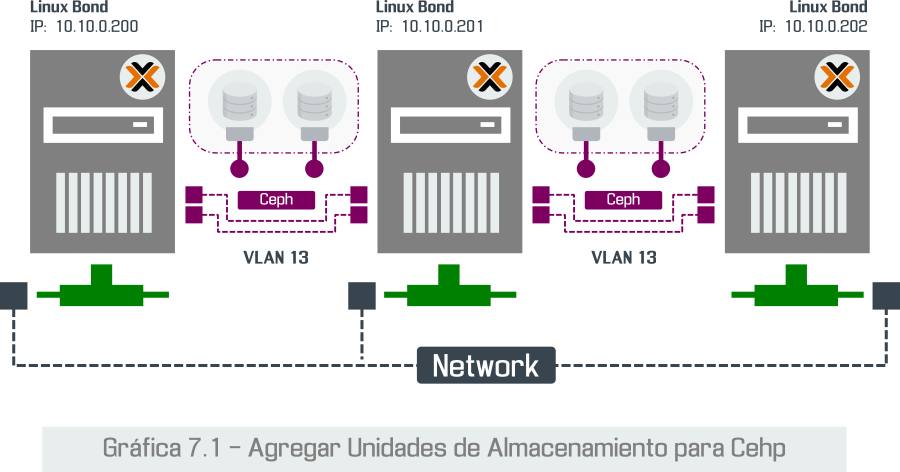

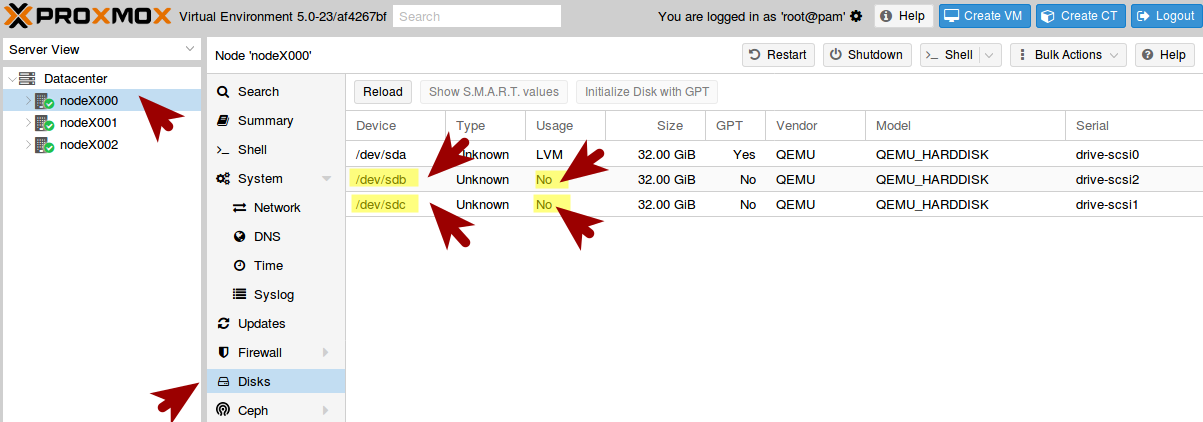

7. Agregar Disco Duros en Nodos para Ceph

Gráfica 7.1 - Agregar Unidades de Almacenamiento para Ceph

Las unidad de almacenamiento (Disco Duro) donde se instaló PROXMOX, se utiliza específicamente para el Sistema Operativo, la capa Hipervisor PROXMOX, Swap & KSM, almacenar ISO's instaladores, Templates LXC, VM's Locales, entre otras cosas. Esta unidad no se puede utilizar para formar parte del "Storage Ceph" por tal razón es necesario agregar a los Nodos, "Unidades de Almacenamiento Extra" para el aprovisionamiento de espacio del "Storage Ceph" del Cluster.

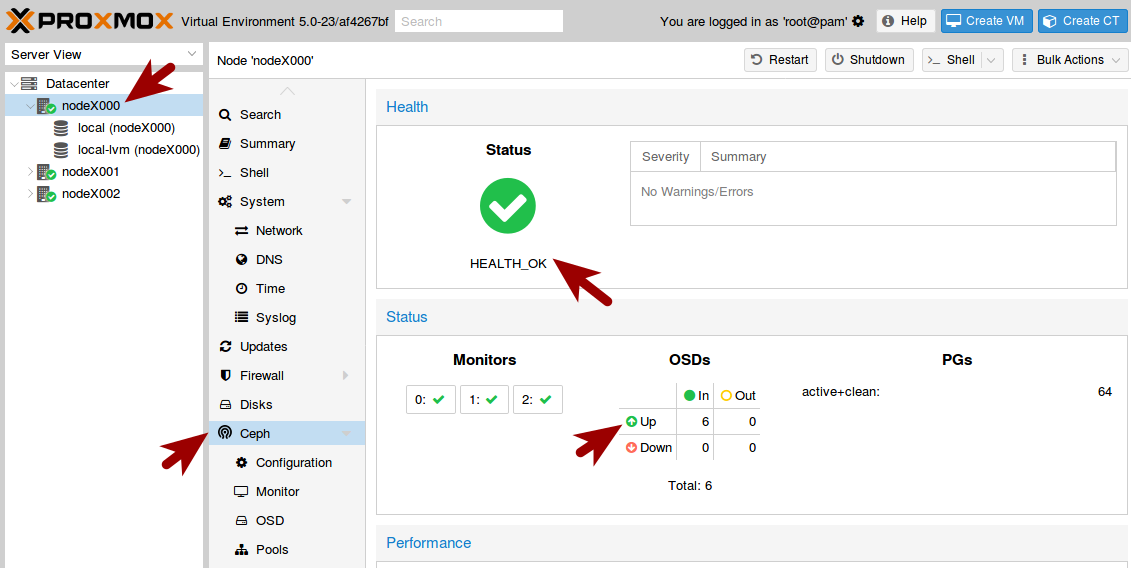

8. Instalar librerías Ceph y Activación de Servicio

Después de reiniciar los Nodos, instalamos las librerias Ceph.

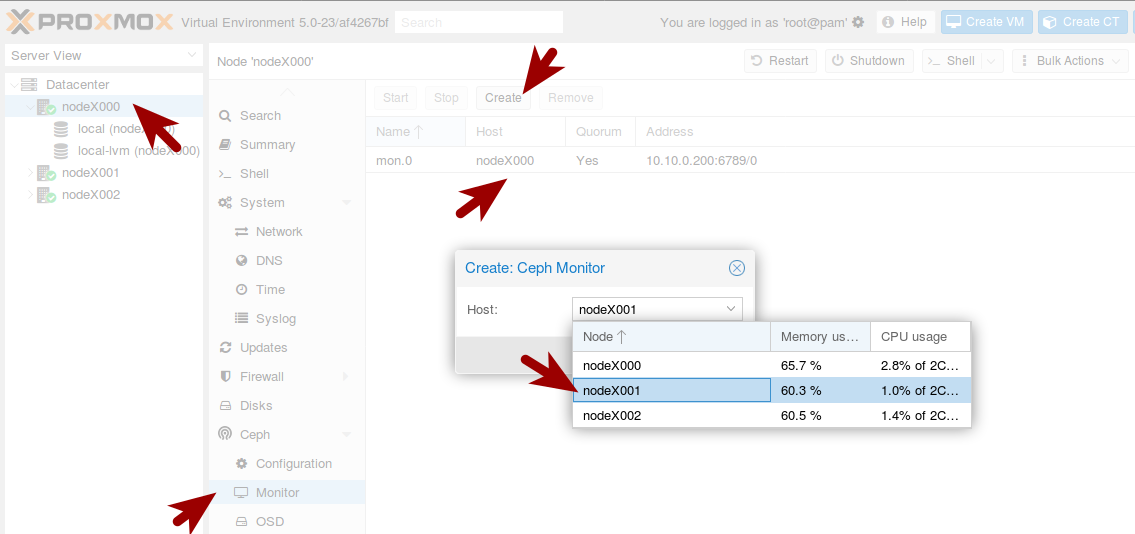

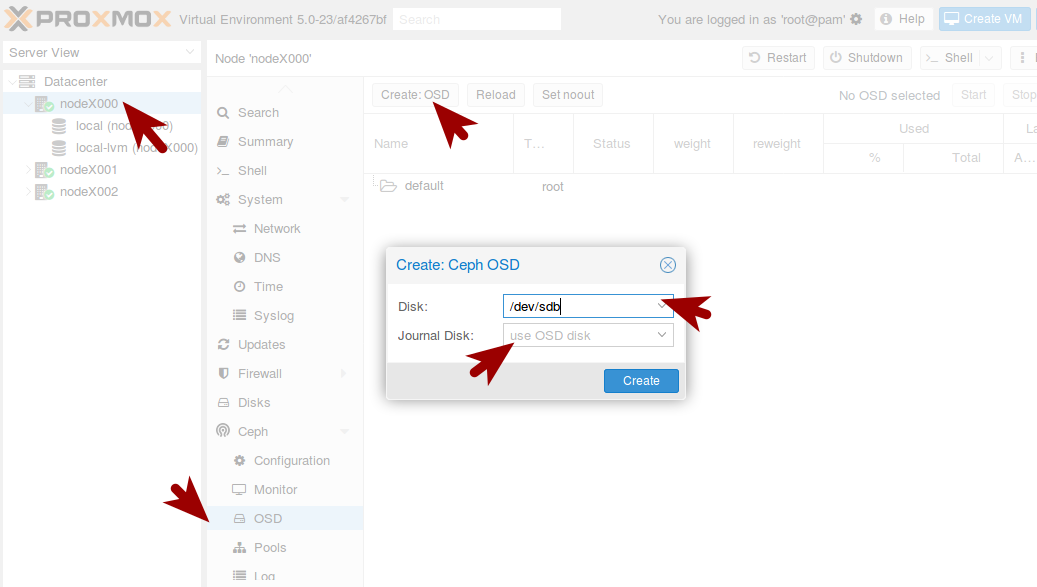

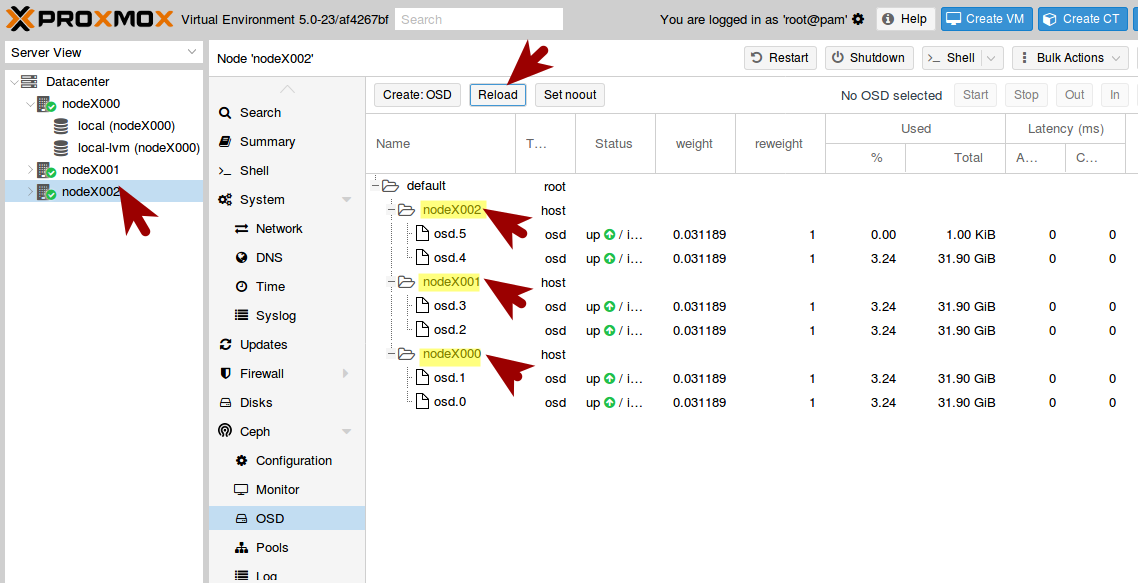

9. Presentar "Bloques de espacio" al Cluster

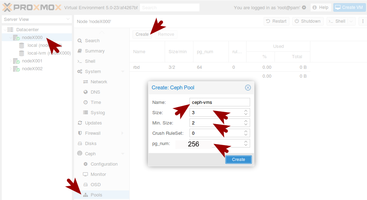

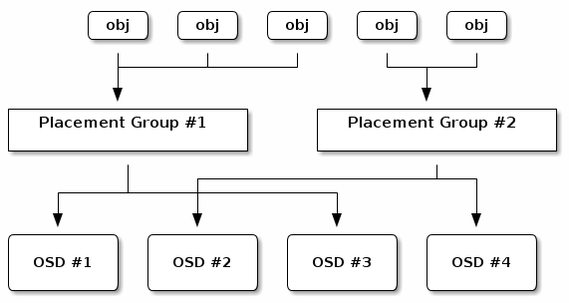

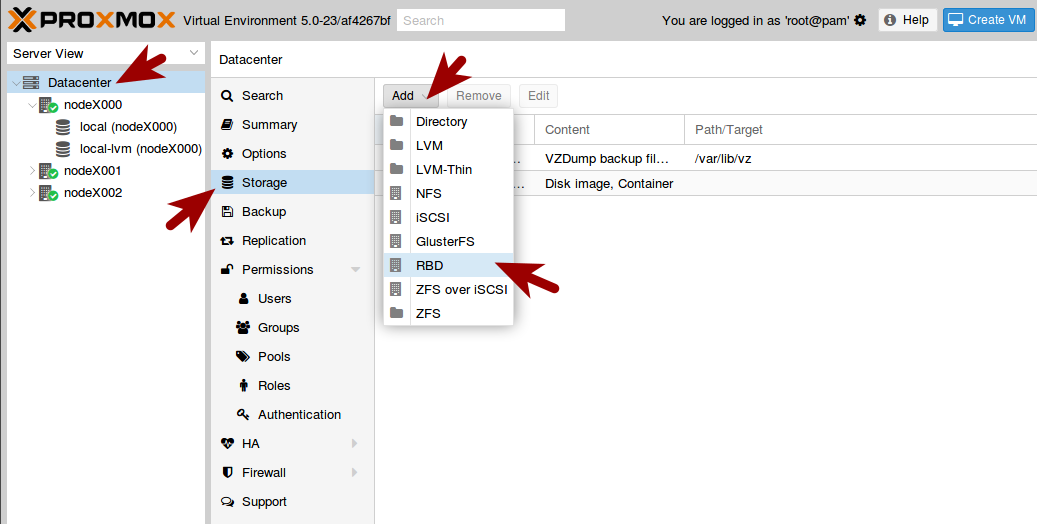

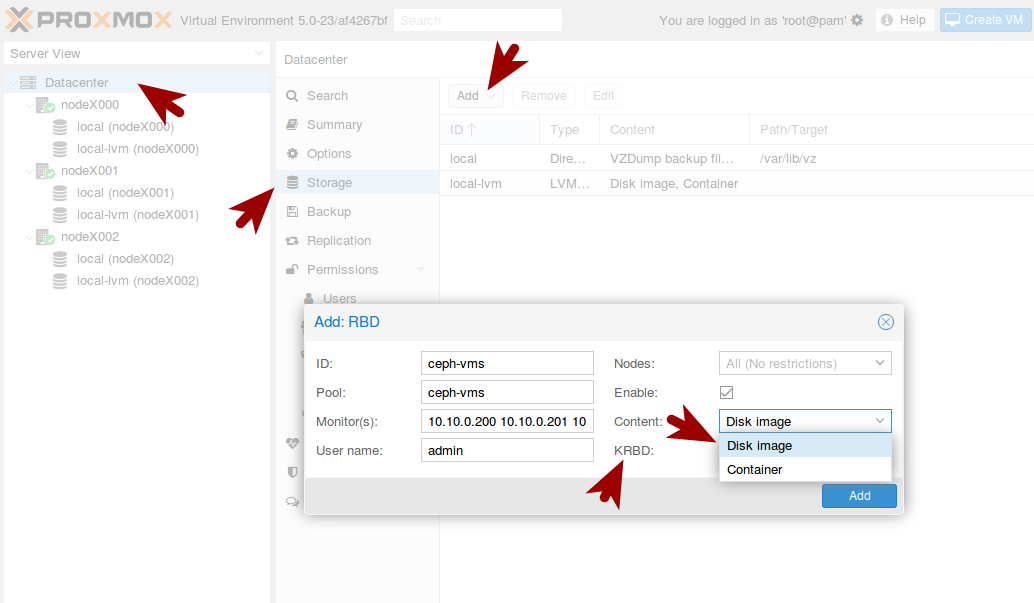

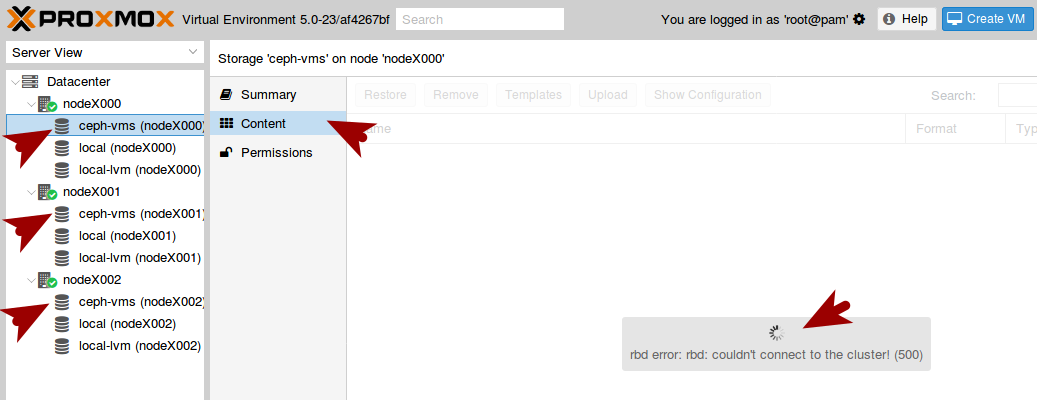

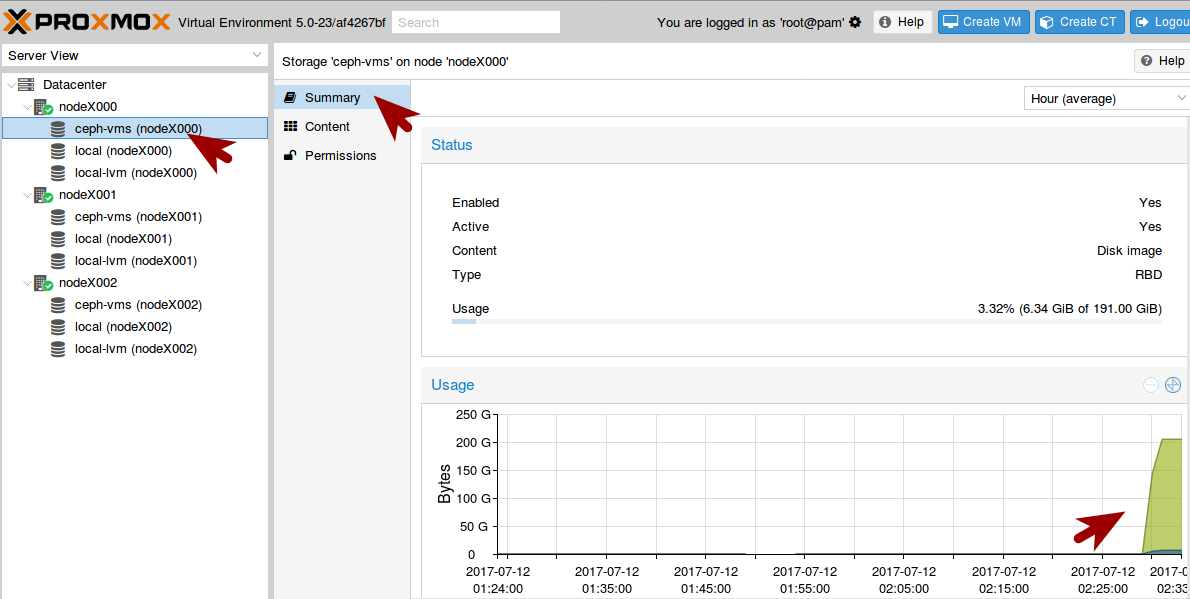

Después de habilitar las "Unidades de Almacenamiento Extra", el siguiente paso es presentar el "Storage Ceph" al Cluster como un "Storage RBD". Antes de iniciar con la configuración es conveniente explicar la relación de Pools y RBD para así comprender lo que vamos a configurar con el Administrador Web de PROXMOX.

9.2.2 Información técnica:

9.4.2 Descripción de campos de pantalla "9.4.1 Crear RBD para Ceph-vms"

10. Pruebas de "Migración" y "Alta Disponibilidad"

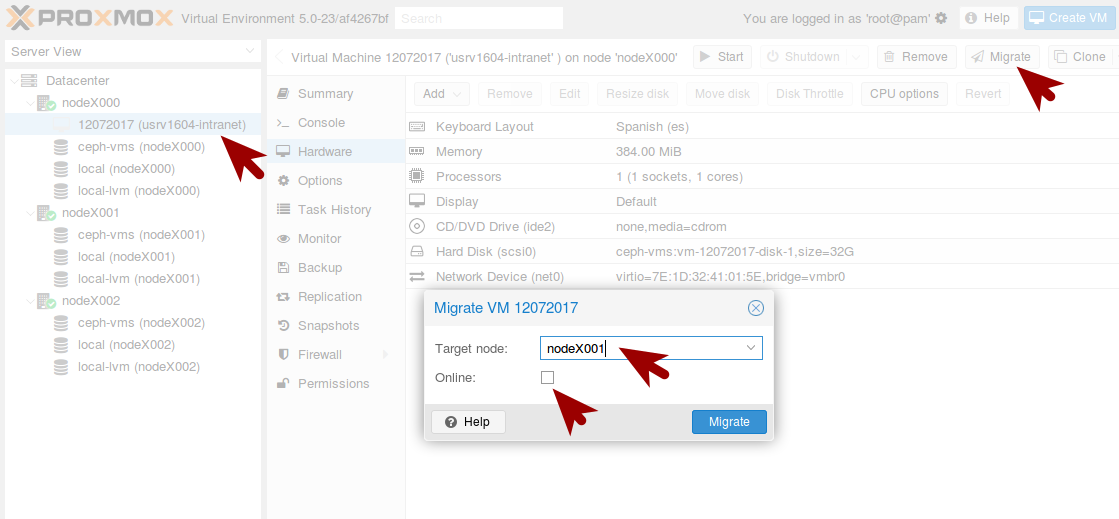

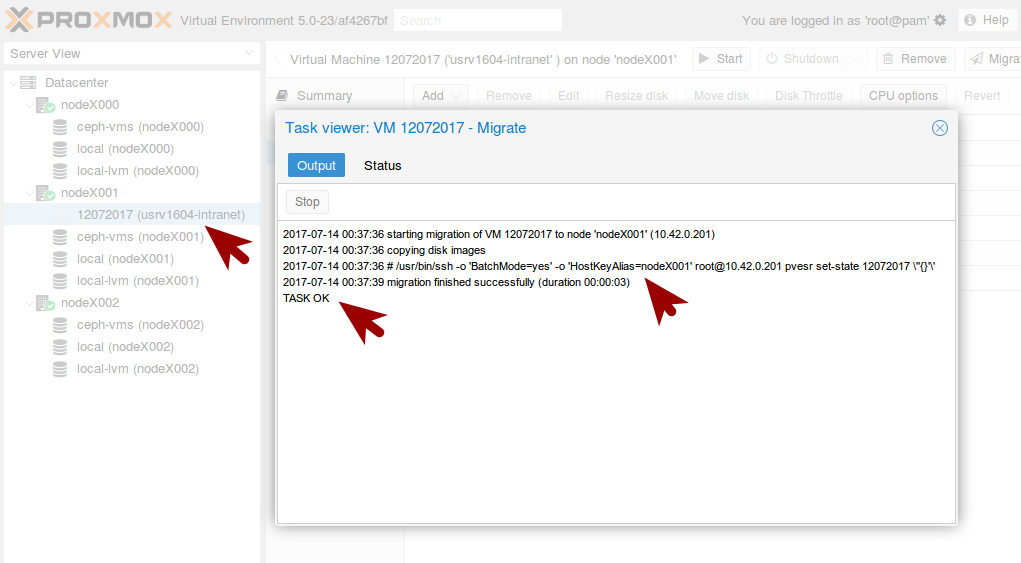

Estamos llegando a la fase final de este artículo, donde inicia lo divertido y justificamos el tiempo empleado al ver los resultados. En esta etapa vamos a comprobar el correcto funcionamiento del Cluster y del Storage Ceph, efectuando migración de "Máquinas Virtuales" entre los Nodos para luego activar reglas de "Alta Disponibilidad".

Antes de iniciar es conveniente puntualizar lo siguiente:

Toda vez la migración "Offline" tanto de ida como de regreso funcione adecuadamente, podemos concluir que la comunicación entre los Nodos y Storage funciona adecuadamente. El siguiente paso es encender la VM y efectuar las mismas prueba, tomando en cuenta que este escenario solo muestra los conceptos y que en algún momento puede quedarse la VM debido a lo limitado del escenario.

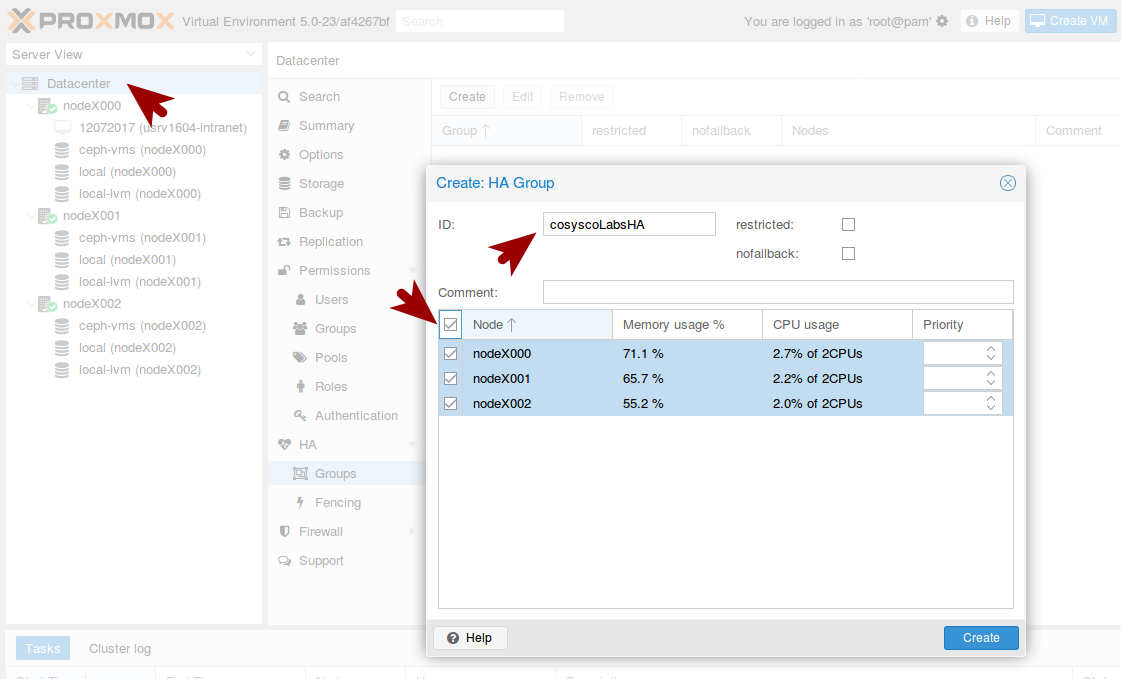

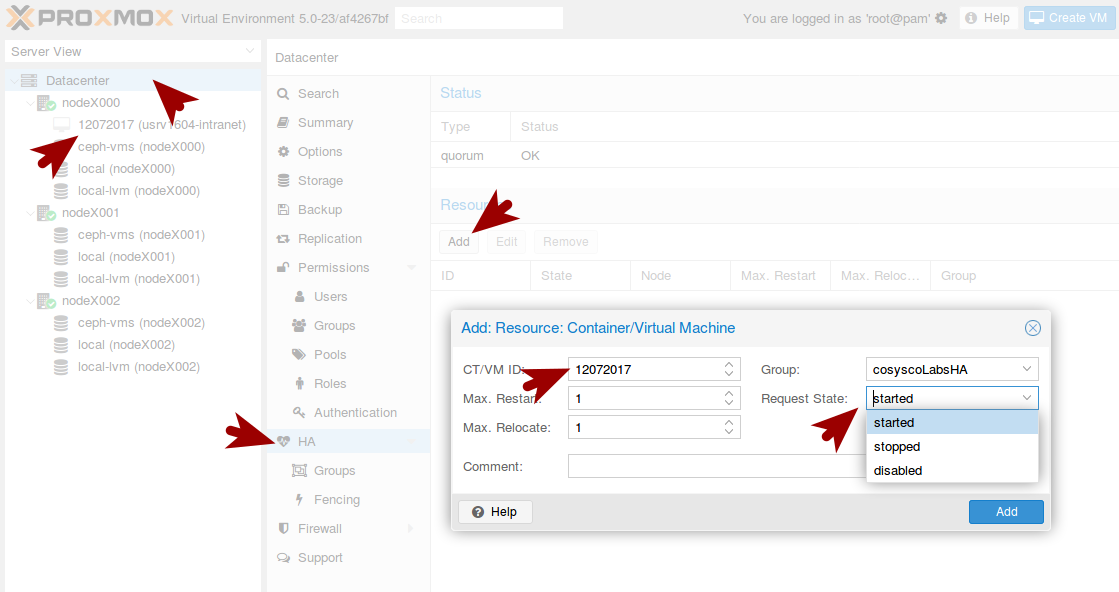

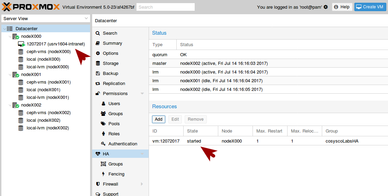

10.5 Habilitar Alta Disponibilidad

Una de las ventajas de crear un "Cluster" es la habilitación de "Alta Disponibilidad" que en resumen, es definir reglas de migración automática a las "Máquinas Virtuales", entre los Nodos en caso de eventualidades. Más información: https://pve.proxmox.com/wiki/High_Availability

10.8 Descripción de campos de pantalla "10.7 Agregar Reglas HA"

10.9 Prueba de funcionamiento "Alta Disponibilidad"

Bueno amigos, hemos llegado al final y ahora queda en sus manos el experimentar con el Entorno Virtualizado.

Finalizado PROXMOX Ceph

9 Comments

Maxwell

3/4/2018 09:15:22

Majestuosa explicación, muy bien detallado. Me gustaría que este artículo lo tratara utilizando SAN/NAS en vez de Ceph. Agradecido por todo lo que publicas. Un fuerte abrazo.

Reply

Rafael

3/4/2018 22:27:49

Excelente Manual.

Reply

sistemas

4/26/2018 09:59:49

Hola, impresionante la guia que han montado.

Reply

Ricardo

4/30/2019 05:46:45

Quería felicitaros por la currada del post.

Reply

Ra

6/26/2019 12:59:48

Muy buena guiá, la pienso implementar en un cliente!.

Reply

Ra

6/26/2019 13:04:31

Muy buena guiá, la pienso implementar en un cliente!.

Reply

Stanley

10/6/2019 12:55:07

Excelente explicación.

Reply

Leave a Reply. |

Editor:

Juan Estuardo Hernandez Consultor Software Libre, Organización y Métodos. Acumular información es sólo el primer paso hacia la sabiduría. Pero compartir información es el primer paso hacia la comunidad.

Henry Louis Gates, Jr Condiciones de uso: El contenido del website 911-ubuntu y este artículo en particular, es “Libre” y puede ser consultado por quien lo desee. Por favor “No haga copias de nuestros artículos”. Si desea compartirlo puede referir nuestras publicaciones como un enlace (Link), así las personas interesadas obtendrá nuestras últimas actualizaciones. Como todo en la vida, nada es perfecto, así que si observas algún error o desea mejorar el contenido de estos artículos, puede enviarnos un mensaje el cual será bienvenido. (Formulario al pie de página). Gracias por continuar consultando 911-Ubuntu para Entorno de Oficina y Redes Corporativas. |